Diese neue Entwicklung wird von folgenden Faktoren vorangetrieben: Embedded-Hardware mit geringem Stromverbrauch sorgt für Kosten- und Energieeinsparungen. Die lokale Verarbeitung schützt die Daten und erlaubt den Offline-Betrieb, während Edge-KI die Entscheidungsfindung in Echtzeit bei minimaler Latenz unterstützt. Dies ist für autonome Systeme und die industrielle Automatisierung erforderlich. Da generative KI und große Sprachmodelle (LLMs) immer näher an den Rand des Netzwerks rücken, werden fortschrittliche Komprimierungs- und Optimierungstechniken zunehmend unverzichtbar.

Embedded AI im Aufwind: Markt, Trends und Technologietreiber

Embedded AI entwickelt sich zunehmend zu einem zentralen Treiber moderner Edge-Systeme. Der Markt wächst rasant, getragen von spezialisierten Hardwarekomponenten wie Neural Processing Units (NPUs) und heterogenen Architekturen, die immer häufiger direkt in Mikrocontroller und Systems-on-Chips (SoCs) integriert werden. Dadurch stehen Ingenieure vor der Herausforderung, komplexe Modelle auf Geräten mit begrenzten Speicher- und Rechenressourcen einzusetzen. Techniken wie Quantisierung, Pruning und andere Methoden der Modellkomprimierung sind daher essenziell. Neben der Hardware gewinnen leistungsfähige Bibliotheken und Tools zunehmend an Bedeutung, um KI über verschiedene Plattformen hinweg zuverlässig nutzbar zu machen.

Ein konkretes Beispiel für diesen Trend ist die Kombination von Wake-Word-Erkennung mit Objekterkennung und -verfolgung auf Qualcomm-Snapdragon-Plattformen. YOLOX-basierte Netzwerke für die Objekterkennung werden hierfür eingesetzt, wobei die Inferenz auf die Hexagon-NPU ausgelagert ist. Die NPU wird hierbei nur im Bedarfsfall aktiviert, falls vorher ein entsprechendes wakeword (Audiosignal) gegeben wurde und dieses von einer zweiten, stromsparenderen NPU erkannt wurde. Dieser Ansatz zeigt, wie heterogene Architekturen, die eine NPU mit geringem Stromverbrauch mit Hexagon-DSP kombinieren, Bildverarbeitungsaufgaben in Echtzeit ermöglichen und gleichzeitig die Energieeffizienz aufrechterhalten.

Embedded AI effizient gestalten: Shift Left für smarte KI

Mit der zunehmenden Komplexität eingebetteter KI steigt auch der Bedarf an klar strukturierten Workflowprozessen. Model-Based Design bietet hierfür einen Rahmen: Statt Low-Level-Code zu schreiben, modellieren Ingenieure ihre Algorithmen visuell in Simulink. Anforderungen, Modelle und Testartefakte werden dabei in einem einheitlichen digitalen Thread zusammengeführt, was die Zusammenarbeit und Rückverfolgbarkeit über den gesamten Produktlebenszyklus hinweg unterstützt.

Ein zentraler Vorteil dieses Ansatzes liegt in der frühzeitigen Validierung. Mithilfe von Hardware-in-the-Loop- (HIL-) und Processor-in-the-Loop- (PIL-) Tests lassen sich potenzielle Probleme frühzeitig erkennen und die Entwicklung beschleunigen, ganz im Sinne des „Shift-Left“-Prinzips. Wie dieser Ansatz funktioniert, lässt sich anhand eines Beispiels aus der Automobilbranche erklären. Bei der KI-basierten Trajektorienplanung und -steuerung auf Infineon Aurix TC4x werden neuronale Netzwerksteuerungen vor dem Einsatz mithilfe von Model-Based Design entworfen und validiert. Durch die Nutzung einer Parallelverarbeitungseinheit (PPU) auf der Hardware erzielt diese Lösung im Vergleich zu herkömmlichen Ansätzen eine um 50 Prozent höhere Genauigkeit und 5 Prozent Energieeinsparungen – ein Beispiel dafür, wie strukturierte Workflows und hardwarebewusste Optimierung greifbare Vorteile bieten.

Integrierte Umgebung für die Entwicklung und Bereitstellung von KI

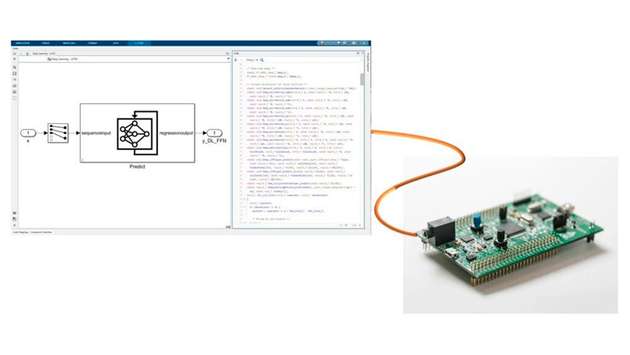

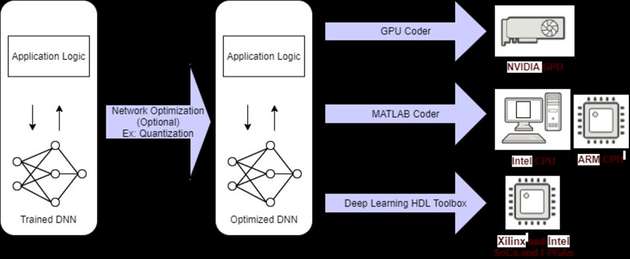

MathWorks bietet eine integrierte Umgebung für die Entwicklung und Bereitstellung von KI auf eingebetteten Systemen. Ingenieure können ihre Modelle in Matlab entwerfen und trainieren oder bereits trainierte Modelle aus Frameworks wie PyTorch, TensorFlow und ONNX importieren. Mithilfe automatischer Codegenerierungstools wie Matlab Coder und GPU Coder lassen sich diese Modelle in optimierten C-, C++-, CUDA- oder HDL-Code für CPUs, GPUs, FPGAs und MCUs übersetzen. Auf diese Weise wird die Lücke zwischen High-Level-Design und Hardware-Implementierung geschlossen.

Zudem sind Verbesserungs-Workflows für Quantisierung, Pruning und Komprimierung in die Toolchain integriert. Sie ermöglichen den Einsatz auf Geräten mit begrenzten Ressourcen, ohne dass die Leistung beeinträchtigt wird. Ergänzend sorgen Verifizierungswerkzeuge wie Polyspace für zusätzliche Zuverlässigkeit, indem sie den generierten Code statisch und dynamisch analysieren, Fehler frühzeitig im Entwicklungszyklus erkennen – oder deren Abwesenheit nachweisen. Gerade in sicherheitskritischen Bereichen sind diese Funktionen von entscheidender Bedeutung, um Compliance und Robustheit zu gewährleisten.

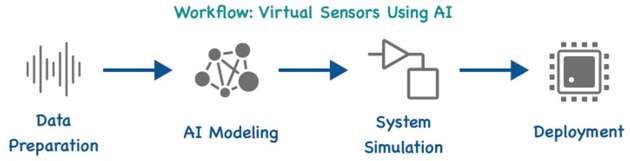

Ein praxisnahes Beispiel für diesen Workflow ist die Temperaturvorhersage für Elektromotoren auf TI-C2000-Hardware. Dabei werden virtuelle Sensormodelle in Matlab oder Python entwickelt und trainiert, für den Einsatz komprimiert und mithilfe von Processor-in-the-Loop-Tests validiert. Dieser Ansatz ersetzt physische Sensoren durch softwarebasierte Schätzfunktionen, wodurch Kosten und Komplexität reduziert werden, während die Genauigkeit erhalten bleibt oder sogar zunimmt.

Zudem findet Embedded AI bereits in zahlreichen Anwendungsbereichen Einsatz: Im Gesundheitswesen wird sie beispielsweise für die Echtzeit-Signalverarbeitung in der EKG-Analyse auf STM32-Boards genutzt. Hierbei werden Deep-Learning- und Signalverarbeitungsalgorithmen kombiniert. Mithilfe automatischer C/C++-Codegenerierung lassen sich Sensordaten in Echtzeit verarbeiten. Auch im Bereich der Arbeitssicherheit kommen eingebettete KI-Lösungen zum Einsatz: Die Erkennung von persönlicher Schutzausrüstung auf Raspberry Pi und die Posenerkennung auf NVIDIA Jetson-Plattformen zeigen, wie eingebettete Bildverarbeitung und GPU-Beschleunigung kompakte, leistungsstarke KI-Lösungen für Überwachung und Compliance ermöglichen.

Fazit

Die genannten Beispiele stehen exemplarisch für einen breiteren Trend: Embedded KI ist nicht länger eine Nischentechnologie, sondern entwickelt sich zu einem Standard für intelligente Systeme in verschiedenen Branchen. Durch strukturierte Workflows und den Einsatz integrierter Toolchains können Ingenieure ihre Entwicklungsprozesse beschleunigen, deren Zuverlässigkeit sicherstellen und die Leistung für Edge-Bereitstellungen optimieren. Da generative KI und fortschrittliche Workflows immer näher an die Edge rücken, werden effiziente Methoden und Optimierung unter Berücksichtigung der Hardware der Schlüssel sein, um ihr volles Potenzial auszuschöpfen.