Selbstfahrende Autos sind die erste Generation von Robotern, die den alltäglichen Lebensraum mit uns teilen. Deshalb müssen Regeln definiert werden, wie sich solche Systeme in kritischen Situationen verhalten sollen. Eine Studie an der Universität Osnabrück zeigt: Menschliche Ethik lässt sich durchaus in die künstliche Intelligenz von Maschinen implementieren, sodass beispielsweise autonome Fahrzeuge bald moralische Dilemmata im Straßenverkehr bewältigen können.

Menschliche Moral verstehen

„Um Regeln oder Empfehlungen definieren zu können, sind zwei Schritte notwendig. Als Erstes muss man menschliche moralische Entscheidungen in kritischen Situationen analysieren und verstehen. Als zweiten Schritt muss man das menschliche Verhalten statistisch beschreiben, um Regeln ableiten zu können, die dann in Maschinen genutzt werden können“, erklärt Prof. Dr. Gordon Pipa, einer der leitenden Wissenschaftler der Studie.

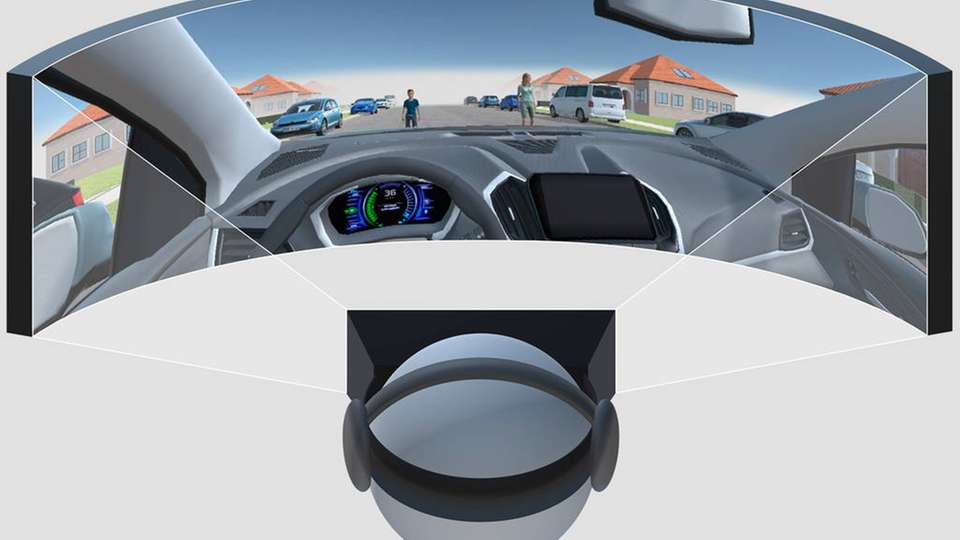

Verhaltensstudie in der virtuellen Realität

Um beide Schritte zu realisieren, nutzten die Autoren eine virtuelle Realität, um das Verhalten von Versuchspersonen in simulierten Verkehrssituationen zu beobachten. Die Teilnehmer der Studie fuhren dazu an einem nebeligen Tag durch die Straßen eines typischen Vorortes.

Im Verlauf der Experimente kam es dabei zu unvermeidlichen und Dilemma-Situationen: Menschen, Tiere oder Objekte standen als Hindernisse auf den Fahrspuren. Um den Hindernissen auf einer der beiden Spuren ausweichen zu können, musste der Proband daher abwägen.

Wertigkeit des Lebens als Regel

Die beobachteten Entscheidungen wurden dann durch eine statistische Analyse ausgewertet und in Regeln übersetzt. Die Ergebnisse weisen darauf hin, dass im Rahmen dieser unvermeidbaren Unfälle moralisches Verhalten durch eine einfache Wertigkeit des Lebens erklärt werden kann - für jeden Menschen und jedes Tier.

Leon Sütfeld, der Hauptautor der Studie, kommentiert: „Das zeigt, dass menschliche moralische Entscheidungen prinzipiell mit Regeln beschrieben werden können und dass diese Regeln als Konsequenz auch von Maschinen genutzt werden könnten.“

Diese neuen Osnabrücker Erkenntnisse stehen im Widerspruch zu dem achten Prinzip des BMVI-Berichtes, das auf der Annahme gründet, dass moralische Entscheidungen nicht modellierbar sind.

Lässt sich Moral modellieren?

Wie kann dieser grundlegende Unterschied erklärt werden? Algorithmen können entweder durch Regeln beschrieben werden oder durch statistische Modelle, die mehrere Faktoren miteinander in Bezug setzen können. Gesetze, zum Beispiel, sind regelbasiert.

Menschliches Verhalten und moderne künstliche intelligente Systeme nutzen dazu im Gegensatz eher komplexes statistisches Abwägen. Dieses Abwägen erlaubt es beiden - dem Menschen und der modernen künstlichen Intelligenz - auch neue Situationen bewerten zu können, denen diese bisher nicht ausgesetzt waren.

In der wissenschaftlichen Arbeit von Sütfeld wurde nun eine solche dem menschlichen Verhalten ähnliche Methodik zur Beschreibung der Daten genutzt. „Deshalb müssen die Regeln nicht abstrakt am Schreibtisch durch einen Menschen formuliert, sondern aus dem menschlichen Verhalten abgeleitet und gelernt werden. So stellt sich die Frage, ob man diese nun gelernten und konzeptualisierten Regeln nicht auch als moralischen Aspekt in Maschinen nutzen sollte“, so Sütfeld.

Wie menschlich sollen Maschinen werden?

„Nun, da wir jetzt wissen, wie wir moralische Entscheidungen in die Maschinen implementieren können, bleiben uns trotzdem noch zwei moralische Dilemmata“, sagt Prof. Dr. Peter König, weiterer Autor dieser Veröffentlichung, und fügt hinzu: „Erstens müssen wir uns über den Einfluss von moralischen Werten auf die Richtlinien für maschinelles Verhalten entscheiden. Zweitens müssen wir uns überlegen, ob wir es wollen, dass Maschinen sich (nur) menschlich verhalten sollen.“