Die Preise pro Gigabite oder Schreib-/Lesegeschwindigkeiten mögen zentrale Auswahlkriterien für Flash-Speicher im IT-Bereich sein. Bei industriellen Anwendungen aber stehen Robustheit und Langlebigkeit im Mittelpunkt. Angaben zum Temperaturbereich und zu mechanischen Eigenschaften scheinen den richtigen Weg zu weisen. Auch Angaben zur Endurance werden von Herstellern gemacht – sind aber oft nicht vergleichbar. Wer geeignete Speicher auswählen und für seine Aufgaben qualifizieren will, sollte die Alterungsprozesse von Flash-Speichern und mögliche Kompensationsmaßnahmen der Hersteller verstehen. Wichtig dabei ist die Frage, wie genau der Speicher von der Anwendung genutzt wird, denn das sollte die Auswahl bestimmen.

Grundlagen: Alterung von Flash

Die Zellen eines NAND-Flashs überstehen nur eine begrenzte Zahl von Löschungen. Ursächlich dafür ist, dass sich in der Oxidschicht, die das Abfließen der Elektronen aus dem Floating Gate verhindert, bei jeder Erzeugung des Tunnel-

effekts durch die Löschspannung Elektronen mit erhöhtem Energieniveau ansammeln. Damit verschiebt sich auf Dauer die Schwellwertspannung, bis die Zelle nicht mehr lesbar ist.

Hinzu kommt als zweiter Alterungseffekt das Entstehen leitender Pfade durch die Oxidschicht. Über diese verliert die Zelle allmählich ihren Ladungszustand und damit das gespeicherte Bit. Hohe Temperaturen beschleunigen den Effekt und dieser wird auf jeden Fall ein Problem, wenn die möglichen P/E-Zyklen (Programmier-/Lösch-Zyklen) zur Neige gehen. Folglich nimmt die Retention, also die Fähigkeit, Informationen zu bewahren, am Ende des Lebenszyklus extrem ab.

Der Anwender kann sowohl bei einem Single-Level-Cell-NAND (SLC) wie bei einem Multi-Level-Cell-NAND (MLC) ursprünglich von einer Retention von 10 Jahren ausgehen. Am Ende des Lebenszyklus sinkt sie aber auf nur ein Jahr. Dieser Punkt ist beim MLC nach 3.000 P/E-Zyklen erreicht, beim SLC erst nach 100.000 P/E-Zyklen. Deshalb bleibt das SLC die erste Wahl für besonders anspruchsvolle Anwendungen.

Bei Triple-Level-Cell-NAND-Chips (TLC) sinkt die ursprüngliche Retention von nur einem Jahr nach 500 P/E-Zy-

klen sogar auf nur drei Monate. Das ist für industrielle Anwendungen ungeeignet. Die im Consumer-Bereich verbreiteten TLC-Speichermedien sind kostengünstig, weil hier drei Bit pro Zelle gespeichert werden. Das ist gleichzeitig der Grund für das schnelle Verblassen der Informationen: Es müssen acht verschiedene Ladungsniveaus unterscheidbar sein, um diese drei Bit zu lesen – schon ein geringer degenerativer Effekt macht das unmöglich.

Stressige Nachbarn

Neben dem Abfluss von Ladung aus alternden Zellen führen weitere Effekte zu Lesefehlern. Beim Schreiben werden zum Beispiel die Zellen in der Umgebung der zu programmierenden Zelle gestresst. Die umgebenden Zellen weisen eine leicht erhöhte Spannung auf (Program Disturb). Mit der Zeit erhöht sich in den Zellen die Schwellwertspannung und es kommt zu Lesefehlern, die nach dem Löschen des Blocks wieder verschwinden. Auch das Lesen führt zu Stress (Read Disturb). Beide Effekte erzeugen Bit-Fehler, die vom Fehlerkorrekturverfahren (Error Correcting Code, ECC) ausgeglichen und durch ein Löschen des Blocks gelöst werden müssen. Besonders stark ist der Effekt bei Anwendungen, die immer wieder dieselben Daten lesen. Deshalb müssen zur Fehlerkorrektur auch im Inneren eines Speichers, der nur gelesen wird, ständig Blöcke gelöscht und Pages geschrieben werden. Ein weiterer Mechanismus, den der Controller eines Flashspeichermediums steuert: Da beim Ausfall von Zellen der ganze Block als Bad Block markiert werden muss, wird mit dem Wear Leveling eine gleichmäßige Nutzung der physischen Speicher-

adressen sichergestellt.

Der Austausch von Speicherkomponenten sollte in industriellen Anwendungen tunlichst vermieden werden. Mit dem Wissen um die Alterungsprozesse wird daher nach besonders langlebigen SSDs gesucht. Dabei gibt es zwei Maße, mit denen Hersteller die Lebensdauer von SSDs angeben: Terabytes Written (TBW) und Drive Writes Per Day (DWPD). TBW sagt aus, wie viel Daten über die Lebenszeit insgesamt geschrieben werden können. DWPD gibt an, wie viele Daten innerhalb der Garantiezeit pro Tag maximal geschrieben werden können. Entsprechende Benchmarks sind sehr aufwändig und Kunden sind auf die Angaben des Herstellers angewiesen. Es ist allerdings nicht ganz klar, wie aussagekräftige diese Werte wirklich sind.

Messungen mit einer 480-GB-SSD ergaben zum Beispiel je nach Messverfahren eine Lebensdauer von 1.360 TBW, 912 TBW oder 140 TBW. Der imposanteste TBW-Wert ergibt sich beim sequenziellen Schreiben. Den zweiten Wert erhält man bei „Client Workload“, der dritte bei „Enterprise Workload“. Der Client Workload orientiert sich am Nutzerverhalten eines PC-Anwenders und erzeugt zum größeren Teil sequenzielle Zugriffe. Der Enterprise Workload simuliert das Verhalten eines Servers mit Multi-User-Umgebung, die zu 80 Prozent Random-Zugriffe erzeugt. Bei diesen Belastungstests handelt es sich um Vorgaben der Standardisierungsorganisation JEDEC und mit diesen Standards wäre eigentlich eine Vergleichbarkeit gegeben. Allerdings machen viele Hersteller keine Angaben zur Workload und werben mit sequenziellen Schreibwerten. Da, wie das Beispiel zeigt, zwischen diesem und dem Enterprise Workload ungefähr der Faktor zehn liegen kann, ist äußerste Vorsicht bei nicht näher spezifizierten auffällig hohen Endurance-Werten angebracht.

Der Anwender sollte auch bei solchen Tests die Ergebnisse vorsichtig bewerten, die über eine sehr lange Zeit auf SSDs schreiben bis diese defekt sind und daraus ableiten, wie lange eine SSD hält. Seriöse Hersteller garantieren nach der erreichten TBW-Anzahl immer noch ein Jahr Datenspeicherung. Das berücksichtigen solche Tests nicht, und SSDs, die weit über die erlaubte Grenze hinaus beschrieben werden, halten am Ende vielleicht nur noch ein paar Tage die Daten. Überraschungen nach einem längeren Urlaub sind so vorprogrammiert.

Neben beiden internen Vorgängen Wear Leveling und ECC ist ein dritter besonders wichtig für die Auswahl einer effizienten Speicherlösung: das Mapping zwischen logischer und physischer Adresse. Im Standardverfahren bezieht es sich auf Blöcke. Bei sequenziellen Daten ist das sehr effizient, weil dabei die Seiten eines Blocks hintereinander beschrieben werden. Kontinuierlich gesammelte Videodaten sind ein Beispiel für eine Anwendung, die mit der blockbasierten Zuordnung bedient wird. Bei allen anderen Daten hat das einen Nachteil. Hier werden Seiten in viele verschiedene Blöcke geschrieben. Das bedeutet, bei jedem internen Umschreiben muss pro Page ein ganzer Block gelöscht werden. Das erhöht den Write Amplification Factor (WAF), zu Deutsch Schreibverstärkung. Das Verhältnis zwischen Applikationsdaten und tatsächlich geschriebenen Daten wird ungünstig, die Lebensdauer sinkt. Schlussfolgerung: Wer in der Anwendung überwiegend im Random-Zugriff Daten schreibt, sollte Datenträger mit Page-basiertem Mapping wählen. Hier sorgt die Firmware dafür, dass Daten verschiedenen Ursprungs sequenziell in Seiten eines Blocks abgelegt werden können. Die Zahl der Löschungen sinkt – positiv für die Lebensdauer – und die Schreibperformanz steigt. Nachteil ist die größere Zuordnungstabelle des Flash Translation Layers (FTL). Eine sinnvolle Maßnahme der SSD-Spezialisten für industrielle Anwendungen ist deshalb, den FTL auf einem integrierten DRAM vorzuhalten.

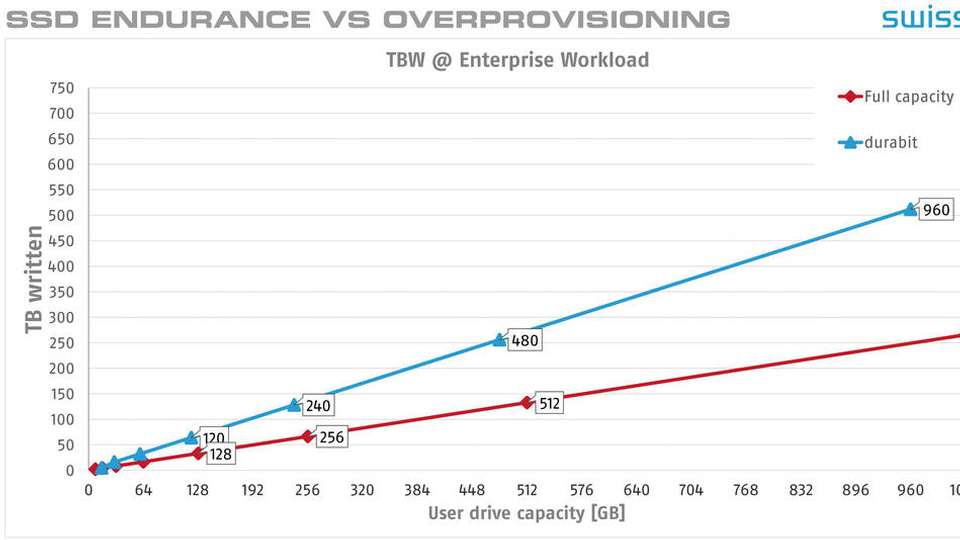

Wer einen hochwertigen Flash-Datenträger für eine industrielle Applikation sucht, wird den Speicherplatz möglichst exakt auf die Anwendung dimensionieren. Zu knapp kalkulieren sollte der Anwender ihn allerdings nicht. Das liegt daran, dass je mehr Platz auf einem Flash-Speicher belegt ist, umso mehr Bits muss die Firmware hin und her schieben. Ein sehr volles Medium erhöht den WAF und senkt dadurch die Lebensdauer. Dieser Effekt lässt sich reduzieren, wenn ein Medium mit Over-Provisioning genutzt wird. Traditionell werden sieben Prozent eines Flashmediums für die Firmware-Vorgänge reserviert – die Diskrepanz zwischen binären und dezimalen GB-Angaben. Der Effekt eines Over-Provisioning ist beeindruckend: Werden statt 7 Prozent 12 reserviert, kann das eine bis doppelt so hohe Endurance beim Enterprise Workload bedeuten.

Arbeitsweise des Controllers ist entscheidend

Die Beispiele zeigen, dass bei der Langlebigkeit von Flash viel von der Arbeitsweise des Controllers abhängt. Das hat dazu geführt, dass in vielen Fällen kostengünstige MLC eingesetzt werden können, wo bisher nur SLC möglich waren. Die angedeuteten Abhängigkeiten zwischen Nutzungsart und Verschleiß sollen dazu einladen, die Auswahl von Speicher applikationsspezifisch vorzunehmen. Der Anbieter sollte hier zu Offenheit hinsichtlich seiner Benchmarks wie auch seiner Firmware-Konfigurationen gedrängt werden. Und natürlich sollte er nach einem aufwändigen Qualifikationsprozess die Langzeitverfügbarkeit des gewählten Flash-Speichers gewährleisten können.