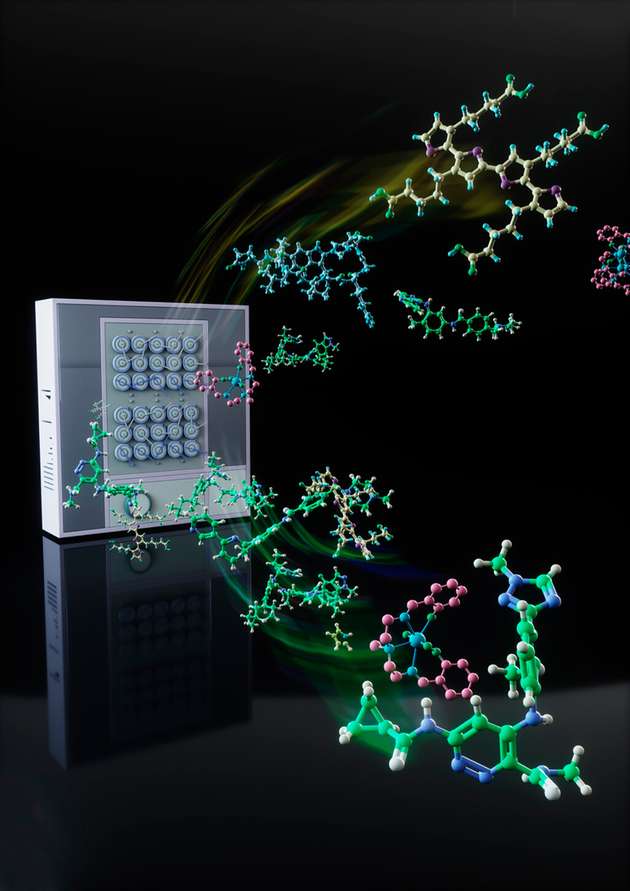

Eine aktuelle Studie von Forschenden der Friedrich-Schiller-Universität Jena untersucht, wie leistungsstark moderne KI-Modelle wie etwa GPT-4 in der Chemie sind und wie sie im Vergleich zu menschlichen Fachleuten abschneiden. Mithilfe eines neu entwickelten Prüfverfahrens namens „ChemBench“ konnte das Team um Dr. Kevin M. Jablonka zeigen, dass KI-Modelle in bestimmten Aufgabenfeldern überzeugen, jedoch auch deutliche Schwächen aufweisen.

„Die Möglichkeiten künstlicher Intelligenz in der Chemie stoßen zunehmend auf Interesse – daher wollten wir herausfinden, wie gut diese Modelle wirklich sind“, erklärt Jablonka, Leiter der Carl-Zeiss-Stiftungs -Nachwuchsgruppe „Polymere in Energieanwendungen" an der Friedrich-Schiller-Universität Jena und dem Helmholtz-Institut für Polymere in Energieanwendungen (HIPOLE) Jena. Im Zentrum der Untersuchung stand „ChemBench", ein von den Forschenden entwickeltes Werkzeug, das mit den Fähigkeiten von Chemikerinnen und Chemikern verglichen wurde.

Mehr als 2.700 Aufgaben im Vergleich

Um die Fähigkeiten der KI zu testen, entwickelte das Team der Universität Jena ein spezielles Prüfverfahren, das reale, in der modernen Chemie anfallende Aufgaben nutzt. Mehr als 2.700 Fragen aus verschiedenen Bereichen der Chemie – von organischer bis analytischer Chemie – wurden in das Werkzeug „ChemBench“ integriert. Sie decken sowohl Grundlagenwissen als auch anspruchsvolle Problemstellungen ab und orientieren sich an typischen Lehrplänen in der Chemie. Die Leistung der KI-Modelle wurde dabei mit der von 19 erfahrenen Fachleuten verglichen, die dieselben Aufgaben bearbeiteten.

Während die Menschen für einen Teil der Studie Hilfsmittel wie Google oder chemische Programme nutzen durften, mussten die KI-Modelle ohne solche externen Ressourcen auskommen. „Die Modelle konnten ihr Wissen also ausschließlich aus dem Training mit vorhandenen Daten ziehen“, erläutert Jablonka. „Wir haben zusätzlich auch zwei KI-Agenten mit Zugriff auf externe Tools getestet – diese konnten allerdings nicht mit den besten Modellen mithalten“, ergänzt der Chemiker. Neben der Richtigkeit der Antworten bewerteten die Forschenden auch, wie gut die KI ihre eigene Antwortsicherheit einschätzte.

KI ist schneller und effizienter, Menschen sind reflektierter und selbstkritischer

Die Ergebnisse der Untersuchung zeigen ein gemischtes Bild, berichtet Jablonka: „Bei sogar sehr anspruchsvollen lehrbuchartigen Fragen zeigten sich einige KI-Modelle als leistungsstärker als Menschen.“ Während die Chemikerinnen und Chemiker in manchen Fällen jedoch offen zugaben, eine Frage nicht sicher beantworten zu können, zeigten die besten KI-Modelle eine gegensätzliche Tendenz: Sie gaben oft mit großer Selbstsicherheit Antworten – selbst, wenn diese inhaltlich falsch waren.

„Fehlerhafte Antworten mit hoher Überzeugung können zu Problemen führen“

„Besonders auffällig war dies bei Fragen zur Interpretation chemischer Strukturen, etwa zur Vorhersage von NMR-Spektren“, stellt Jablonka fest. Hier schienen die Modelle klare Antworten zu liefern, auch wenn sie teilweise grundlegende Fehler machten. Die menschlichen Fachleute hingegen zögerten häufiger und hinterfragten ihre eigenen Schlussfolgerungen. „Diese Diskrepanz ist ein entscheidender Faktor für die praktische Anwendbarkeit von KI in der Chemie“, ordnet Jablonka ein, denn: „Ein Modell, das fehlerhafte Antworten mit hoher Überzeugung liefert, kann in sensiblen Bereichen der Forschung zu Problemen führen.“

„Unsere Forschung zeigt, dass KI eine wichtige Ergänzung für menschliche Expertise sein kann – nicht als Ersatz, sondern als wertvolles Werkzeug, das in der Arbeit unterstützt“, resümiert Jablonka. „Damit legt unsere Studie den Grundstein für eine engere Zusammenarbeit von KI und menschlicher Expertise in der Chemie.“