Der ungeheure Energiebedarf von Künstlicher Intelligenz (KI) gerät zunehmend in den Blickpunkt der Diskussion. Kein Wunder, schon 2019 warnte eine US-Studie davor, dass allein das Training eines einzigen neuronalen Netzwerks so viel CO2-Emissionen verursacht wie fünf (konventionelle) Autos.

Schlechte Treibhausgas-Bilanz

Allein das Training des GPT-3-Modells (also der seit Ende 2022 öffentlich zugänglichen Version von ChatGPT) verbrauchte so viel Strom, wie ein mittleres Atomkraftwerk in etwa einer Stunde produzieren kann (nämlich 1.287 MWh).

Inzwischen verursacht der Energiebedarf der gesamten Informations- und Kommunikationstechnik etwa 2 bis 4 Prozent der globalen Treibhausemissionen – so viel wie der weltweite Flugverkehr.

Und der Bedarf wächst: So schätzen Wissenschaftler, dass der Energieverbrauch Künstlicher Intelligenz bis zum Jahr 2027 auf bis zu 134 Twh anwachsen könnte. Darüber hinaus benötigt KI-Training auch Wasser in erheblicher Menge - das Training des GPT-Modells soll um die 700.000 l Kühlwasser verschlungen haben.

Beispielloser Bedarf an Rechenleistung

Das Training großer KI-Modelle benötigt Rechenleistung in beispielloser Menge – so will Nvidia bis Ende 2024 mehr als 2 Millionen KI-Rechenbeschleuniger des jüngsten Typs H100 „Hopper“ verkaufen. Laufen diese alle unter Volllast,benötigen sie mit 1,6 GW mehr Strom, als einer der größten Atomreaktoren liefern kann.

Neben dem Training erfordert natürlich auch der Betrieb von KI-Systemen Energie. So wird der durchschnittliche Energiebedarf einer Anfrage an ChatGPT auf 3 bis 9 Wh geschätzt.

Würden alle der neun Milliarden täglichen Suchanfragen von KI beantwortet, wäre mit einer Verdreissigfachung des Energiebedarfs zu rechnen. Die Integration von ChatGPT in Microsofts BING und von Gemini in Googles Suchmaschine weist darauf hin, dass die Zahl der KI-generierten Suchantworten in jedem Fall erheblich zunehmen wird.

Einsatz von Künstlicher Intelligenz nimmt zu

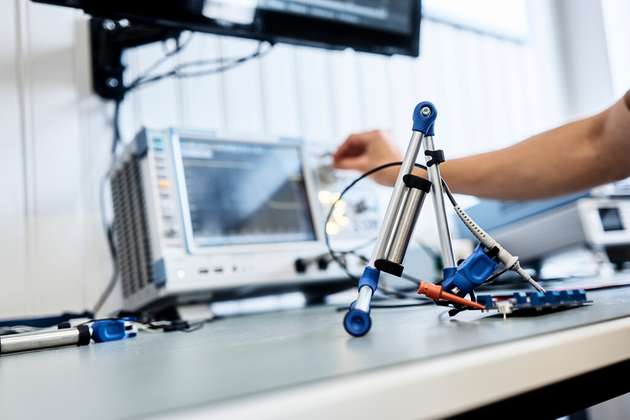

„Auch in der Medizintechnik und Industrie, zum Beispiel in der Produktion, nimmt der Einsatz von KI zu. Zwar verspricht der Einsatz von KI in der Industrie, Prozesse effizienter zu gestalten und Produktionsausfälle zu verhindern. Doch die Steigerung der Maschineneffizienz führt auch hier zu einem deutlich höheren Energiebedarf“, geht Viacheslav Gromov, Geschäftsführer des KI-Anbieters Aitad ins Detail.

Aitad ist ein deutscher Embedded-KI-Anbieter. Das Unternehmen befasst sich mit der Entwicklung, Testung und Serienfertigung von KI-Elektroniksystemen, insbesondere in Verbindung mit maschinellem Lernen im Industriekontext (vor allem Systemkomponenten).

KI muss energieeffizienter werden

Vor diesem Hintergrund muss die Entwicklung und der Einsatz von KI energieeffizienter werden, nicht nur um Kosten zu sparen, sondern auch um der Energieknappheit und dem zur Energieerzeugung notwendigen Ressourcenverbrauch zu begegnen. Nicht zuletzt zwingen die globale Erwärmung oder auch geopolitische Ereignisse zu einem sparsamen Umgang.

Natürlich ist die Lösung nicht der Verzicht auf KI, sondern die Fokussierung auf mehr Energieeffizienz bei ihrem Einsatz. So können KI und smarte Sensoren nicht nur die Industrie transformieren, sondern auch die Produktion energieeffizienter gestalten.

Der zentrale Fokus sollte aber schon bei der Entwicklung neuronaler Netzwerke liegen sowie auf der Fragestellung, an welcher Stelle die gewünschten Informationen aus den von Sensoren erfassten Daten extrahiert werden.

Große Einsparmöglichkeiten bestehen auf dem für die industrielle Nutzung besonders wichtigen Feld der diskriminativen KI. Anders als generative KI (wie ChatGPT, Midjourney, Gemini, et cetera), wird diese Art von KI nicht zur Erschaffung von Inhalten sondern zur Analyse und Auswertung von Daten genutzt.

Diskriminative KI gibt also Antworten auf an Geräte und Maschinen gerichtete Fragen wie: „Was passiert gerade, und was wird in Zukunft geschehen?“.

Größer heißt nicht immer leistungsfähiger

Letzten Endes hängt der Energieverbrauch im Wesentlichen von der Größe des Künstlichen Neuronalen Netzwerks und folglich den dahinterstehenden, meist parallelisierten Rechenoperationen ab.

Das betrifft sowohl die Trainingsphase als auch den Einsatz des Modells. Was liegt also näher, als die Modelle so klein und effizient in der Verarbeitung wie möglich zu halten? Dabei bedeutet klein nicht zwangsläufig geringere Leistungsfähigkeit.

Seit wenigen Jahren ist es möglich, KI auch auf kleinsten Halbleitern – von der MCU bis zur FPGA - laufen zu lassen - als Embedded System. Wenn man einen Cortex-M-Mikrocontroller (gegebenenfalls mit NPU und DMA) mit gleichen MAC-Parallel-Operationen mit einem typischen Intel i-PC-Prozessor vergleicht, kann man durch natürliche Beschränkungen im Spezifischen um Faktor 20 bis 60 effizienter werden.

„Derartige Embedded-KI arbeitet vollautark an der Netzwerkkante – mit dem großen Vorteil, dass sie alle vom Sensor erhaltenen Daten in Echtzeit auswerten kann und schon deshalb kaum Konnektivität erfordert.

Für die Industrie wird Embedded-KI in vielen Anwendungsfeldern immer wichtiger und hilft gleichzeitig dabei, den Energieverbrauch massiv einzudämmen“, erklärt Gromov genauer.

Energiesparendes Training auf einem Standard PC?

Das beginnt bereits beim Training von KI-Modellen für Embedded-KI-Systemkomponenten. Während große Modelle für das Training eine umfangreiche Server-Infrastruktur benötigen (teilweise müssen zehntausende GPU-Server – die mehr als 400.000 US-Dollar pro Server kosten - verbunden sein) ist die KI-Entwicklung für ein Embedded-System oft schon auf einem Standard PC möglich.

Das liegt natürlich auch daran, dass Embedded-KI sehr spezifische Fragestellungen beantwortet, wie zum Beispiel Vorhersagen über den Gesundheitszustand eines Antriebs, einfache Sprachsteuerungen (mit Erkennung auch komplexerer Wortgefüge), Überwachung und Prüfung von Schweißnähten, oder Beurteilung des Gesundheitszustands von Zähnen an Hand der beim Putzen erfassten Ultraschallgeräusche - und unzählige weitere Use Cases, zum Beispiel zur Entlastung des Service oder der Vorhersage von Ausfällen bei Industrierobotern.

Da Embedded-KI-Systeme stets stark ressourcenbeschränkt sind, ist auch der Energiebedarf sehr gering, je nach Use Case werden nur wenige Milliampere benötigt. Das bedeutet, dass diese Systeme mit Batterie betrieben werden können, in vielen Fällen wäre sogar Energy Harvesting möglich.

Embedded-KI spart Strom und ist vielseitig

Auch wenn Embedded-KI-Systeme keine Allzweckwaffe sind – ihr Einsatz ist prinzipiell überall dort möglich, wo Sensoren zum Einsatz kommen. Um Energie zu sparen und so mehr Effizienz bei gleichzeitig besserer Klima-Bilanz zu erreichen, sind sie ideal.

Angenehme Nebeneffekte sind die viel tiefer mögliche Analyse der Sensordaten, die Echtzeitfähigkeit und Wahrung des Datenschutzes - es werden ja nicht die Sensordaten übertragen, sondern nur die Auswertungsergebnisse. Nicht zuletzt dürften Entwicklungs- und Stückkosten deutlich unter denen vernetzter KI-Systeme liegen.

„Mit Hilfe von Embedded-KI lässt sich der KI-Einsatz dezentralisieren, so dass auch in großen vernetzten Produktionsbetrieben unter deutlich geringerem Energieeinsatz gearbeitet werden kann, ohne auf die Vorteile von KI zu verzichten. Um zukunftsfähig und ressourcenschonend zu bleiben, sollte daher wo immer möglich und erforderlich auf Embedded-KI gesetzt werden“, so Gromov abschließend.