Künstliche Intelligenz (KI) ist ein bisschen wie der Dschinni ist aus der Flasche, der sich nicht wieder einfangen lässt. Die neue Technologie ist mächtig und ihr Potenzial enorm. Nicht umsonst stand KI daher dieses Jahr auch im Zentrum des Weltwirtschaftsforums in Davos. Genauso groß sind aber auch die Risiken.

Balance zwischen Künstlicher Intelligenz und Regulierung

Die aktuelle Debatte um die von Google Gemini generierten KI-Bilder zeigt besonders illustrativ, wie limitiert die Technologie trotz allem beeindruckenden Fortschritt noch ist. Entscheidend wird sein, die Balance zwischen Neuerung und Regulierung zu finden. Außerdem brauchen wir eine Strategie, wie wir mit den gesellschaftlichen Auswirkungen umgehen. Denn KI verändert die Art und Weise, wie wir arbeiten, grundlegend.

Auch wenn Italien wieder einmal damit droht, ChatGPT zu blockieren: Keine Regierung der Welt kann es sich leisten, KI ganz zu verbieten. Der wirtschaftliche Schaden wäre größer als die Risiken, die die neue Technologie mit sich bringt. Denn dann wandern Innovationen einfach in andere Länder ab.

Klar ist aber auch, dass wir Regeln für den Einsatz von KI definieren müssen, um die Gefahren in den Griff zu bekommen. Die DSGVO kann hier als Blaupause dienen. Weltweit gibt es bereits verschiedene Initiativen, vom AI Act der EU bis zu Joe Bidens Executive Order zu „Safe, Secure and Trustworthy Development and Use of AI“. Doch das ist erst der Anfang. In den kommenden Jahren wird die Regulierung weiter zunehmen.

Wo besteht akuter Handlungsbedarf?

Insbesondere im Bereich Data Ownership gibt es viele offene Fragen. Ist es zum Beispiel ethisch vertretbar, wenn generative KI einen Künstler oder Autor imitiert, ohne dass dieser angemessen dafür entlohnt wird? Schon mehrfach gab es Klagen gegen OpenAI wegen Urheberrechtsverletzungen, zuletzt von der New York Times.

Schließlich schafft die KI ja nichts Neues, sondern verarbeitet nur die Daten, mit denen sie trainiert wurde. Um Nutzern im Fall von Klagen wegen Urheberrechtsverletzungen zu unterstützen, bieten OpenAI, Google Microsoft und andere Tech-Firmen bereits Rechtsschutz an.

Auch in puncto Datenschutz und Datensicherheit besteht noch Nachholbedarf. Denn Daten, die in ein KI-Modell einfließen, lassen sich mit den richtigen Tricks auch wieder herausziehen. Wie einfach das geht, hatten Forscher Ende letzten Jahres gezeigt: Indem sie ChatGPT mehrfach dasselbe Wort wiederholen ließen, gelang es ihnen, Trainingsdaten aus dem KI-Modell zu extrahieren. Künftig müssen wir uns also auch mit Datendiebstahl via KI auseinandersetzen, wobei es sehr schwierig wird, solche Fälle nachzuweisen.

Künstliche Intelligenz übernimmt keine Verantwortung

Ein anderes großes Problem ist die Schuldfrage: Wer kann verantwortlich gemacht werden, wenn eine KI eine Fehlentscheidung trifft? Ein Computer ist nicht haftbar, und wie eine KI zu einer Entscheidung kommt, lässt sich nicht nachvollziehen. Daher sollte eine Technologie niemals über Leben und Tod bestimmen - und auch nicht darüber, ob ein Kunde eine Versicherungspolice erhält oder nicht.

Ob und wie selbstständig eine KI agieren darf, muss immer auf die Risikostufe abgestimmt sein. Voll autonome KI werden wir daher in kritischen Bereichen vermutlich niemals sehen. Ganz anders sieht es bei Anwendungen mit niederem Risiko aus. Es wäre nicht verwunderlich, wenn irgendjemand in zwei bis drei Jahren noch auf einer Website in einer Chat Box mit einem realen Menschen spricht.

Eine KI-Steuer ist sinnvoll

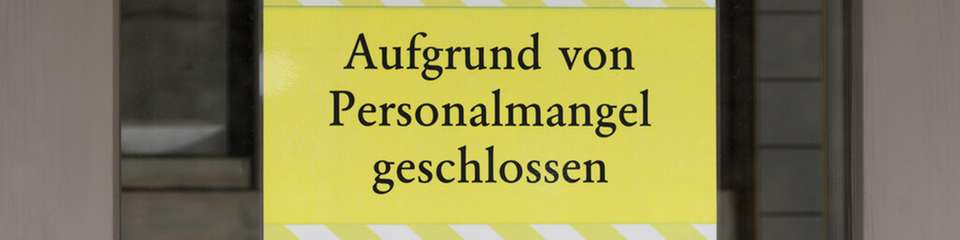

Gerade bei einfachen, wiederkehrenden Standardaufgaben wird KI menschliche Mitarbeiter ersetzen. Viele Menschen fürchten daher um ihren Arbeitsplatz. Zu Recht - wie die Entwicklung des vergangenen Jahres zeigt. Etliche große Unternehmen haben bereits Umstrukturierungen wegen KI angekündet. Gleichzeitig entstehen durch KI natürlich wieder neue Jobs und hilft Mitarbeitern dabei, ihre Fähigkeiten weiterzuentwickeln.

Trotzdem müssen wir uns mit den gesamtgesellschaftlichen Auswirkungen beschäftigen. Eine KI-Steuer, wie sie etwa von Elon Musk oder Andrew Ng angeregt wurde, könnte hier ein guter Lösungsansatz sein. Laut einer Studie des Internationalen Währungsfonds (IWF) wird sich Künstliche Intelligenz auf fast 40 Prozent aller Arbeitsplätze auswirken, in den fortgeschrittenen Volkswirtschaften sogar auf 60 Prozent.

In der Hälfte dieser Fälle wird die KI die Menschen aber nicht ersetzen, sondern unterstützen und ihre Produktivität steigern. Gerade in der Entwicklung ist der Einsatz von KI unverzichtbar, um den Fachkräftemangel zu bewältigen und die immer kürzeren Release-Zyklen zu stemmen.

Das sollten Unternehmen jetzt tun

Künftig wird die Fähigkeit, KI-Tools richtig einzusetzen, entscheidend für den Erfolg sein. Unternehmen sollten daher stärker in Weiterbildung investieren und das Thema priorisieren. Mit Blick auf KI-Anwendungen, die Entscheidungen allein treffen oder den Entscheidungsfindungsprozess unterstützten werden, ist außerdem wichtig, Teststrategien entsprechend weiterzuentwickeln. Continuous Testing und Monitoring ist hier zentral.

Es gilt, zu verfolgen, ob das KI-System vom erwartbaren Verhalten abweicht, wie sich dies auf angeschlossene Applikationen auswirkt und ob korrigierende Maßnahmen erforderlich sind. In diesem Zusammenhang sind Unternehmen auch gut beraten, ausschließlich mit KI-Anbietern zusammenzuarbeiten, die sich ethischen Grundsätzen in der KI-Entwicklung verschrieben haben.

Außerdem sollten sie sich auf die zunehmende Regulierung vorbereiten, um Risiken zu minimieren. Wichtig ist hier, von Anfang an auf eine saubere Datenhygiene zu achten. Mit einer One-Model-Per-Customer-Strategie sind Unternehmen in der Lage, Datendiebstahl via KI zu vermeiden und alle Daten eines Kunden auf Wunsch wieder zu löschen. Außerdem empfiehlt es sich, genau zu tracken, aus welchen Quellen die Daten stammen.