Die Studie „Erklärbare KI – Anforderungen, Anwendungsfälle und Lösungen“ befasst sich mit dem aktuellen Stand von erklärbarer KI und untersucht praxisnahe Beispiele aus der Gesundheitswirtschaft und der Produktion. Übersichtlich aufbereitet und mit anschaulichen Grafiken und Videos sind die Ergebnisse der KI-Studie nun auch auf einer neuen Microsite online nachzulesen.

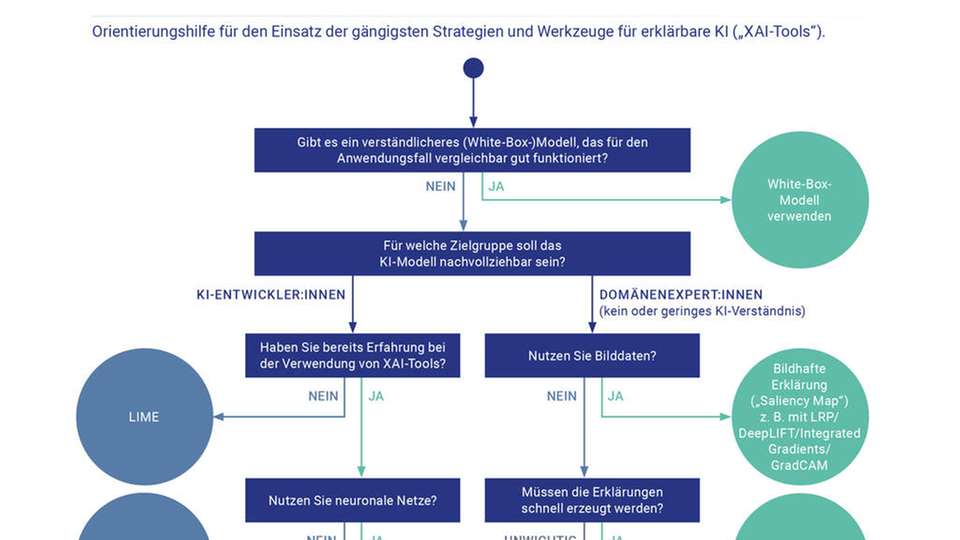

Orientierungshilfe für KI-Anwender

Für die Untersuchung befragte die Begleitforschung zum Technologieprogramm „Künstliche Intelligenz als Treiber für volkswirtschaftlich relevante Ökosysteme“ (KI-Innovationswettbewerb) über 200 KI-Experten aus Unternehmen und Forschungseinrichtungen zum Thema „Erklärbare KI“ im Auftrag des Bundesministeriums für Wirtschaft und Energie.

„Die Studie richtet sich primär an diejenigen, die KI-basierte Produkte und Dienstleistungen entwickeln oder anbieten wollen,“ erklärt Dr. Tom Kraus, einer der Autoren. „Viele KI-Anwender fragen sich, welche konkreten Anforderungen und Lösungsansätze es gibt. Mit der Studie möchten wir eine möglichst praxisnahe Orientierungshilfe geben in einem Anwendungsfeld von KI, das bisher hauptsächlich von der Wissenschaft oder von einigen wenigen Hightech-Konzernen adressiert wird.“

Bei den Teilnehmern der Umfrage kommen schon heute sowohl „White-Box“-Modelle, wie etwa statistische beziehungsweise probabilistische Modelle oder Entscheidungsbäume, als auch „Black-Box“-Modelle wie neuronale Netze zum Einsatz. Für die Zukunft erwarten die befragten KI-Experten allerdings eine stärkere Nutzung von „Black-Box“-Modellen, vor allem von neuronalen Netzen. Die Bedeutung von Erklärungsstrategien wird daher in Zukunft weiter zunehmen, wobei sie je nach Branche unterschiedlich groß ausfallen kann.

Entscheidungsbaum für erklärbare KI

In der Gesundheitsbranche ist die Erklärbarkeit von Einzelentscheidungen zum größten Teil zwingend erforderlich. Fehlentscheidungen können hier fatale Folgen haben. In der Finanzwirtschaft, dem Produktionsbereich, der Bauwirtschaft und der Prozessindustrie wird erklärbare KI aufgrund von Kundenanforderungen als wichtig angesehen. Systeme, die Einzelentscheidungen nicht erklären können, akzeptieren Kunden und Anwender in diesen Branchen in häufigen Fällen nicht.

Aus den Empfehlungen der Befragten sowie weiteren Erkenntnissen aus eigener Literaturrecherchehaben die Autoren Dr. Tom Kraus und Lene Ganschow eine praktische Orientierungshilfe abgeleitet: einen Entscheidungsbaum für erklärbare KI. Er soll Unternehmen und KI-Anwender bei der Auswahl von Erklärungsstrategien und den ersten praktischen Schritten unterstützen. Dieser interaktive Entscheidungsbaum ist jetzt auf der neuen Microsite zu finden.

Entwicklung von Best Practices

Es gibt jedoch noch einige regulatorische und technische Herausforderungen, wie Lene Ganschow erläutert: „Aus regulatorischer Sicht müssen die Anforderungen an die Erklärbarkeit von KI überhaupt erst einmal geklärt werden. Nur wenn Unternehmen die Anforderungen überhaupt kennen, können sie entscheiden, wie sie ihre Produkte gestalten, und sie auf den Markt bringen.“ Aus technischer Sicht werde es zunächst darum gehen, Best Practices zu erstellen, von denen Unternehmen für sich ableiten können, welche Erklärungsstrategien sich für das eigene Produkt am besten eignen.

Die jetzt veröffentlichte Studie zeigt, dass die Erklärbarkeit von KI heute vor allem für KI-Entwickler und Domänenexperten wichtig ist. Perspektivisch erwarten die befragten KI-Experten, dass sich die Bedeutung für die meisten Zielgruppen in fünf bis zehn Jahren zunehmend angleichen wird. Die Erklärbarkeit von Künstlicher Intelligenz wird also in naher Zukunft auch für Endkunden, für Entscheid:innen im Management sowie interne und externe Prüfer:innen an Bedeutung gewinnen.

.jpg)