Beim maschinellen Lernen ist meist eine enorme Menge an Trainingsdaten Voraussetzung, und die künstliche Intelligenz (KI) lernt, indem sie zahllose vorgegebene Beispiele auswertet. Nicht so beim Reinforcement Learning: Hier werden stattdessen die Rahmenbedingungen definiert.

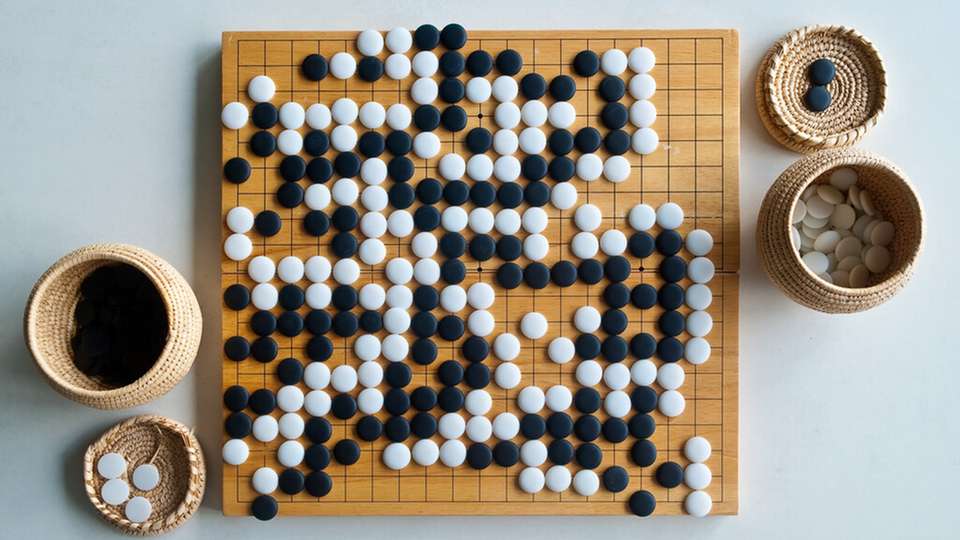

Programmierer legen also fest, welche Aktionen möglich sind und was Erfolg ausmacht, wie zum Beispiel das Besiegen des Gegners oder das Entfernen gegnerischer Spielsteine vom Brett. Das Computerprogramm erhält dann nach jedem Versuch eine Belohnung, je nachdem, ob es die Kriterien eines Erfolges erfüllt hat oder eben nicht.

Kreativität des Computers

„Reinforcement Learning als Spezialvariante des maschinellen Lernens ist dem menschlichen Lernen am ähnlichsten. Wie ein kleines Kind lernt der Algorithmus dabei durch Versuch und Irrtum“, erklärt die Leiterin des Projekts Catherine Laflamme. Da nicht nur vorgefertigte Beispiele ausgewertet werden, können komplett neue Lösungsansätze gefunden werden – auch solche, auf die ein Mensch nie gekommen wäre.

„Es ist ein spielerisches Lernen, und es können sehr kreative Lösungen dabei herauskommen“, erläutert Daniel Bachlechner, Leiter der Gruppe „Advanced Data Analytics“ bei Fraunhofer Austria. Bei Spielen mit zwei Spielern, wie es zum Beispiel bei Go der Fall ist, kann das System auch dadurch lernen, dass es gegen sich selbst antritt. Zusätzlich kann beim Lernen auch Vorwissen, beispielsweise in Form von historischen Spielverläufen, berücksichtigt werden.

Transfer in die Industrie

Nun sollen die Potenziale von Reinforcement Learning in zwei komplexen, realitätsnahen und sehr verschiedenen Steuerungsproblemen auf Herz und Nieren getestet werden: einerseits bei der Priorisierung von Aufträgen und der Routenwahl von FTS in einer Produktionsumgebung und andererseits bei der Steuerung von Antriebssträngen in Kraftfahrzeugen.

Projektpartner für den ersten Anwendungsfall ist die Firma Engel, die in ihrer Fließmontage FTS im Einsatz hat, um Produkte von einem Montageplatz zum nächsten zu transportieren. Die Steuerung funktioniert derzeit über ein programmiertes Regelwerk, das das Zusammenspiel der verschiedenen Fahrzeuge vorgibt.

Dieses kann durchaus komplex werden, denn auch die Versorgung der Montageplätze mit Material erfolgt über die Fahrwege der FTS. Zwar funktioniert die Steuerung, sie kann aber noch verbessert werden, und bei einer Änderung im Prozess, ist die Anpassung mit der derzeit verwendeten Methode äußerst aufwändig. Im Projekt wird nun untersucht, welche Vor- und Nachteile der Einsatz von Reinforcement Learning bei der Steuerung von FTS mit sich bringt.

„Wir wollen uns mit dem Thema Reinforcement Learning auseinandersetzen um das komplexe Zusammenspiel von Mensch und Maschine zu verstehen und zu optimieren“, betont Dominik Pfeiffer-Vogl, Montageleiter bei Engel Austria am Standort Schwertberg.

Kontinuierliches Steigern der Komplexität

Projektpartner im zweiten Anwendungsfall ist die Firma Bosch, und die Fragestellung dreht sich um die Steuerung von Antriebssträngen in Kraftfahrzeugen. Abhängig von Art und Aufbau des Antriebsstrangs (zum Beispiel Verbrenner, Hybrid, E-Antrieb) verfügt der Antriebsstrang über eine Vielzahl an Hauptkomponenten und darin verbauten Aktoren und Sensoren. Diese Subsysteme stehen in einer engen Abhängigkeit zueinander, besitzen also eine hohe Interaktion. Mit zunehmender Komplexität der Subsysteme und wachsender Interaktion zwischen diesen steigt auch die Herausforderung einer möglichst optimalen Steuerung.

Für eine ideal geeignete Steuerung können noch viele weitere Dinge berücksichtigt werden: Bei einem Hybridfahrzeug können beispielweise Routenparameter wie die maximal erlaubte Geschwindigkeit, Straßensteigung, die Distanz zum Zielort sowie die Verfügbarkeit von Ladestationen einen signifikanten Einfluss auf das erreichbare Optimum haben. Sven Dominka, verantwortlich für Forschung und Innovation bei Bosch Engineering in Wien, sieht großes Potenzial, allein durch eine verbesserte Steuerung des Antriebsstrangs, die Effizienz moderner Antriebsstränge weiter zu erhöhen.

„Reinforcement Learning ist die für mich spannendste Art des maschinellen Lernens. Die Entwicklung von Steuerungen für Antriebsstränge ist mit sehr hohen Aufwänden verbunden. Reinforcement Learning birgt das Potenzial, diese Steuerungen weiter zu verbessern und gleichzeitig Entwicklungsaufwände einzusparen. Reinforce soll uns dabei helfen besser zu verstehen, wie wir dieses Potenzial in der Praxis nutzen können“, sagt Sven Dominka.

„Wir wollen ermitteln, wo die Grenzen von Reinforcement Learning liegen, daher werden wir die Komplexität immer weiter steigern und dabei laufend prüfen, wie gut sich die Methode unter den gegebenen Bedingungen noch bewährt. Unser Forschungsfrage lautet vereinfacht ausgedrückt also: Wie groß ist das Potenzial der Technologie in der Praxis?“, erklärt Catherine Laflamme.

Hintergrund Forschungsprojekt Reinforce

Das Projekt „Exploiting the potential of reinforcement learning for continuous optimisation of complex and dynamic systems“ (Reinforce wird unter der Projektnummer 887500 vom Bundesministerium für Klimaschutz, Umwelt, Energie, Mobilität, Innovation und Technologie (BMK) im Rahmen der Ausschreibung 2020 des Programms „IKT der Zukunft“ gefördert. Fraunhofer Austria setzt das Projekt gemeinsam mit der Universität Innsbruck, dem VRVis Zentrum für Virtual Reality und Visualisierung und dem ungarischen Institute for Computer Science and Control – SZTAKI sowie den Firmen Engel und Bosch um. Das Projekt läuft seit Jänner 2022 und endet im Juni 2024 nach einer Laufzeit von 30 Monaten.