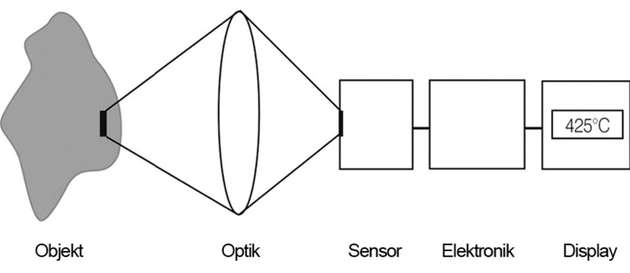

Die Infrarotstrahlung eines Objektes wird mit einer Optik auf einen Sensor fokussiert, der ein der Strahlung proportionales elektrisches Signal erzeugt. Das Signal wird verstärkt und mittels nachfolgender digitaler Signalverarbeitung in eine Ausgabegröße umgesetzt, die der Objekttemperatur entspricht. Der Messwert kann dann auf einem Display angezeigt oder als analoges Signal ausgegeben werden. Das Herzstück einer Wärmebildkamera, der Bildsensor, ist ein 150 Nanometer dünnes Focal Plane Array (FPA) mit Größen von 20 000 bis einer Million Pixel. Jedes Pixel selbst besteht aus 17 × 17 bis 35 × 35 μm² großen Mikrobolometern, deren Widerstandswert sich bei Absorption von Wärmestrahlung ändert. Die Widerstandsänderung bewirkt eine Änderung der über dem Bolometerwiderstand abfallenden Signalspannung, die anschließend ausgewertet wird.

Im Prinzip gilt: Mehr Pixel ergeben mehr Details. Da die Gesetze der Physik aber auch für Wärmebildkameras gelten, kommt es bei Sensoren mit hohen Megapixelzahlen zu negativen Effekten. Wie auch bei Digitalkameras für die Fotografie werden derzeit auf der gleichen kleinen Fläche ständig mehr Pixel untergebracht. Dabei hat ein einzelnes Pixel immer weniger Platz, um Wärmestrahlung einzufangen. Also müssen die schwachen Signale verstärkt werden. Das erhöht aber gleichzeitig das im Signal enthaltene Rauschen, wodurch störende Bildpunkte und Ungenauigkeiten in der Temperaturmessung entstehen. Die dem entgegenwirkende, softwareseitige Rauschunterdrückung retuschiert das aufgenommene Bild. Das bedeutet, dass nicht nur das Rauschen, sondern auch feine Bildstrukturen geglättet werden. Einige der höher auflösenden Infrarotkameras versuchen den Detailreichtum zu verbessern; entweder durch Interpolation oder Überlagerung verschiedener Bilder, die sich durch mechanische Bewegungen des Chips im Subpixelbereich ergeben.

Das überforderte Pixel

Neben dem Rauschen ergibt sich noch ein zweites Problem: Vergleichbar mit einem Wasserglas können immer kleinere einzelne Pixel nur eine bestimmte Menge an Wärmestrahlung aufnehmen, bevor sie „überlaufen“. Ist bei dieser Überstrahlung ein Bildbereich exakt abgebildet, sind in anderen Bereichen keine Details mehr erkennbar.

Doch auch die oft vernachlässigte Güte des Kameraobjektivs spielt eine entscheidende Rolle. Was nutzt ein Sensor mit höchster Pixelanzahl, wenn das Objektiv nicht in der Lage ist, die vom Messobjekt abgestrahlte infrarote Energie möglichst verlustfrei an den Bildsensor weiterzugeben? Ist der vom Objektiv maximal auflösbare, einzelne Bildpunkt größer als das einzelne Pixel des FPA, werden mehr als ein Pixel gleichzeitig belichtet. Das führt zu deutlichen Unschärfen. Die effektive Auflösung ergibt sich immer erst im Zusammenspiel von Optik und Sensorik.

Jedes Pixel braucht Zeit und Speichervolumen

Je höher die Auflösung einer Wärmebildkamera, umso mehr tauchen neben den qualitativen Auswirkungen weitere unangenehme Nebeneffekte auf. Die bei Aufnahmen mit der Kamera anfallende Datenflut muss vor dem Speichern verarbeitet werden. Hierbei stellen schon Schnittstellen mit begrenzten Live-Übertragungsraten eine erste Hürde dar. Dann beansprucht die Übertragung eine gewisse Zeit und führt zu einer langsameren Abtastfrequenz der Videofunktion. Auch sollte man den hohen Platzbedarf der Wärmebilder auf dem Computer und den angeschlossenen Speichermedien bedenken.

Ebenfalls ein Thema ist die korrekte Anwendung. Wärmebildkameras verfügen, genau wie normale Digitalkameras, über ein Gesichtsfeld, den field of view (FOV), der beispielsweise als Teleobjektiv 6 °, als Standardoptik 26 ° und als Weitwinkelobjektiv bis zu 90 ° betragen kann. Mit zunehmender Entfernung vom Objekt vergrößert sich der erfasste Bildbereich und damit auch der Bildausschnitt, den ein einzelnes Pixel erfasst.

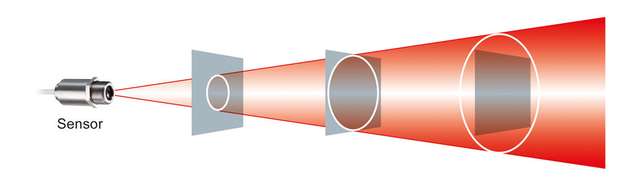

Die optischen Auflösung des Messgerätes muss abhängig von der Größe des Messobjekts und der Entfernung zwischen Messobjekt und Sensor ausgewählt werden. In der linken Grafik wird aufgrund eines zu großen Messflecks, die Wärmestrahlung der wesentlich kühleren Leiterplatte mit einbezogen, was zu erheblichen Verfälschungen des Temperaturmesswertes führt.Der Messfleck der Kamera darf daher nicht größer als die Größe des Messobjekts sein.

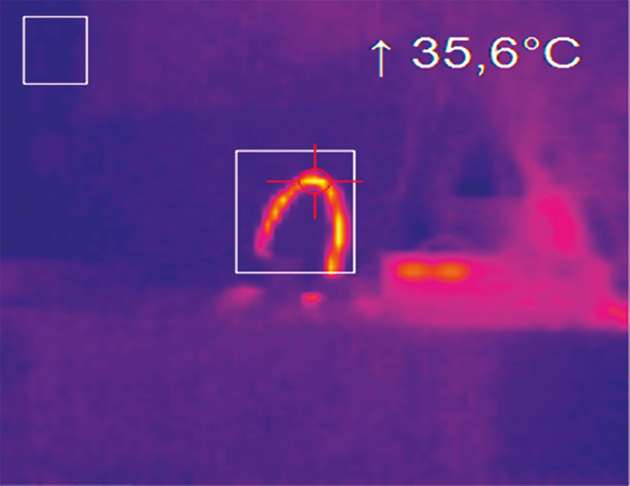

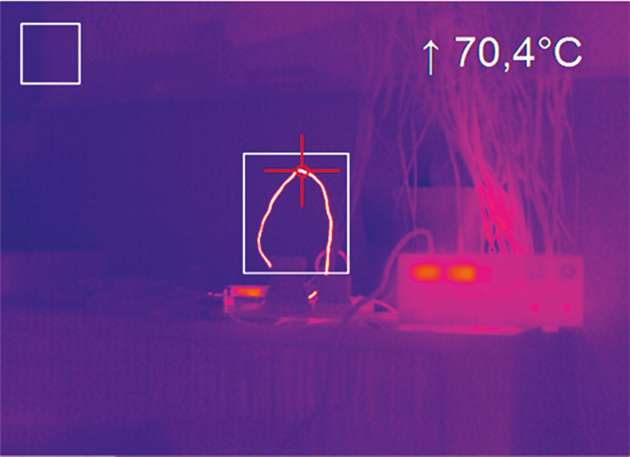

Daraus folgt, dass bei sehr kleinen Messobjekten oder großen Entfernungen zwischen Wärmebildkamera und Messobjekt hohe Auflösungen unabdingbar sind. In einem Versuch habt Optris bei einer Temperaturmessung an einem Draht bei gleicher Entfernung und gleichen Umweltbedingungen zwei verschiedene Auflösungen benutzt. Während bei 640 × 480 Pixel ein korrekter Hotspot von 70,4 °C detektiert wurde, ergab die Messung bei einer Auflösung von 80 × 80 Pixel nur die Hälfte.